2025年2月24日,由北京大学计算机学院与360公司联合研发的32B模型Tiny-R1-32B-Preview正式亮相,仅以5%参数量,逼近DeepSeek-R1-671B的性能。该研究得到了国家自然科学基金委项目(U20A20179、62372009)的资助,得到了北大临港科创中心在算力资源方面的支持。

核心突破:小模型,大能量

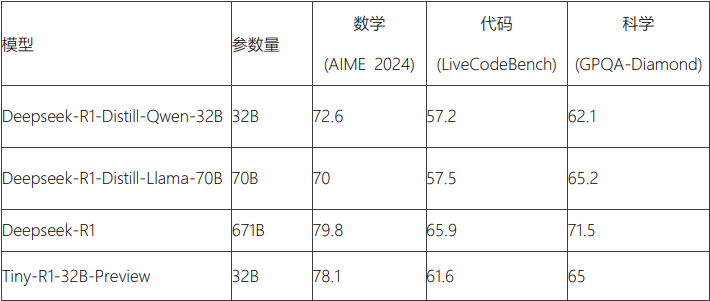

▪ 数学领域:以78.1分(AIME 2024评测)逼近原版R1模型(79.8分),仅差1.7分,远超DeepSeek-R1-Distill-Llama-70B(70.0分);

▪ 综合性能:在编程(LiveCodeBench 61.6分)、科学(GPQA-Diamond 65.0分)领域全面领先最佳开源70B模型DeepSeek-R1-Distill-Llama-70B;

▪ 效率跃迁:仅需5%参数量,推理成本大幅降低。

技术革新:领域专精+模型融合

研究团队使用“分治-融合”策略:

▪ 基于DeepSeek-R1生成海量领域数据,分别训练数学、编程、科学三大垂直模型;

▪ 通过Arcee团队Mergekit工具智能融合,突破单一模型性能上限,实现多任务均衡优化。

开源承诺:推动技术普惠

▪ 模型仓库:https://huggingface.co/qihoo360/TinyR1-32B-Preview

▪ 即将公开完整技术报告、训练代码及部分数据集;

▪ 践行开源精神,助力AI社区共筑高效推理新生态。

研发团队表示:“Tiny-R1-32B-Preview的成功是站在了巨人的肩膀上,受益于开源社区精神,结合DeepSeek-R1蒸馏、DeepSeek-R1-Distill-32B增量训练、模型融合等技术,使用360-LLaMA-Factory训练而来,未来我们也将持续探索更轻量、更强大的模型,推动AI技术普惠化进程,并回馈开源社区。”

北大团队成员合影: 吴钰晗、江子涵、刘文睿、周俊廷、崔斌、杨仝

360团队成员合影: 孙林、赵光香、简小奇、林伟宏、朱永福、贾长娥、张苓琳、吴金柱、胡塞尔、张向征

▌来源:北京大学新闻网